0

Lista vacía

No has añadido ningún curso

En la era digital actual, la generación y acumulación de datos se ha convertido en una corriente constante e imparable. Empresas, organizaciones e incluso individuos se encuentran inmersos en un océano de información que puede proporcionar conocimientos valiosos y oportunidades insospechadas. Sin embargo, este tesoro de datos no puede ser aprovechado completamente sin las herramientas adecuadas para su procesamiento y análisis. Aquí es donde entra en juego el concepto fundamental del procesamiento por lotes en el entorno del Big Data.

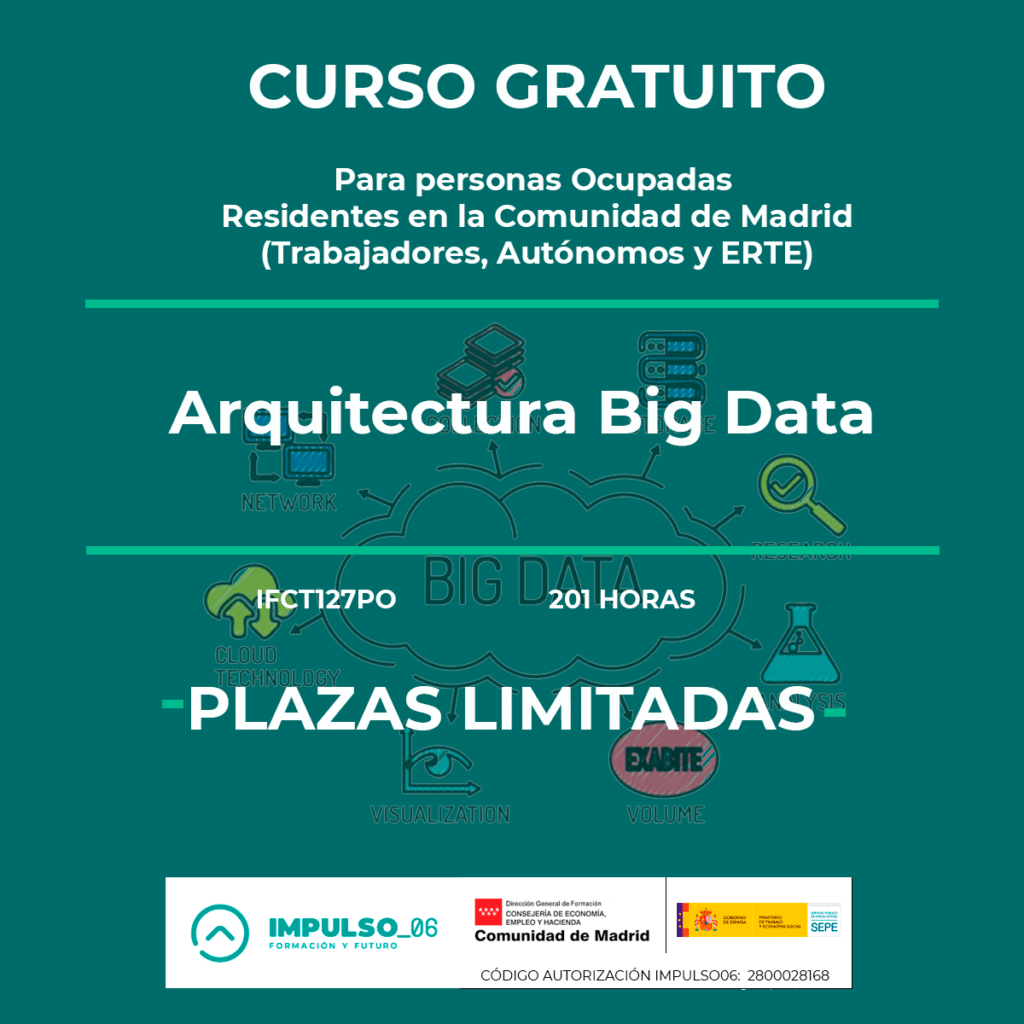

Antes de sumergirnos en las profundidades del procesamiento por lotes en Big Data, permítenos ofrecerte un regalo: nuestro curso gratuito de arquitectura de Big Data. Aprende las bases esenciales y prepara tu travesía hacia el éxito en el mundo del análisis de datos

Tambien te pueden interesar nuestro curso gratis de Tecnologías disruptivas y nuestro curso gratis de competencias digitales. Aprovecha nuestros cursos gratis online.

Tambien te pueden interesar nuestro curso gratis de Tecnologías disruptivas y nuestro curso gratis de competencias digitales. Aprovecha nuestros cursos gratis online.

Imagina que eres el responsable de una cadena de tiendas minoristas que opera en varias ubicaciones. Cada día, se generan miles de transacciones, registros de inventario y datos de ventas en diferentes puntos de venta. ¿Cómo puedes extraer información significativa de esta marea de datos para tomar decisiones comerciales informadas? Aquí es donde el procesamiento por lotes se convierte en tu aliado más confiable.

A medida que avanzamos en este viaje para dominar el procesamiento por lotes en el contexto del Big Data, es crucial comprender la importancia y el potencial que esta metodología ofrece. Desde empresas hasta investigadores y más allá, el procesamiento por lotes desbloquea un mundo de oportunidades para transformar datos masivos en conocimientos significativos. Acompáñanos en este emocionante recorrido mientras exploramos las herramientas clave y desentrañamos los secretos detrás de un procesamiento por lotes efectivo y eficiente.

En el vasto universo del Big Data, Hadoop emerge como un gigante que sostiene los cimientos del procesamiento por lotes. Imagina Hadoop como el maestro constructor de un edificio masivo de datos, capaz de manejar y procesar enormes volúmenes de información de manera efectiva y escalable. En esta sección, exploraremos los fundamentos de Hadoop y desvelaremos cómo este robusto marco se ha convertido en la columna vertebral del procesamiento por lotes en el mundo del Big Data.

La historia de Hadoop tiene sus raíces en un proyecto liderado por Doug Cutting y Mike Cafarella en 2002, que buscaba indexar y buscar el contenido web en la Universidad de Washington. Inspirado por un juguete de peluche de elefante de su hijo, Cutting nombró al proyecto «Hadoop». A medida que el proyecto evolucionó y atrajo la atención de la comunidad tecnológica, se convirtió en un componente fundamental del ecosistema de Big Data.

Hadoop se compone de varios módulos interconectados que trabajan en conjunto para lograr el procesamiento por lotes a gran escala. Dos componentes centrales son el Sistema de Archivos Distribuidos de Hadoop (HDFS) y el Motor de Procesamiento de MapReduce.

El HDFS es como la bodega gigante del edificio de datos, donde se almacenan los archivos de manera distribuida en múltiples nodos de un clúster. Esto permite el acceso rápido y confiable a los datos, incluso cuando los conjuntos son de tamaño colosal.

El Motor de Procesamiento de MapReduce es el constructor del edificio, descompone tareas complejas en tareas más pequeñas y las distribuye en los nodos del clúster para su procesamiento paralelo. Cada nodo opera en sus datos locales y los resultados se combinan al final. Imagina que estás resolviendo un rompecabezas gigante; MapReduce divide el rompecabezas en pequeñas secciones para que cada trabajador (nodo) pueda resolver su sección y, finalmente, unir todas las partes para revelar la imagen completa.

Para comprender mejor cómo Hadoop funciona en el mundo real, consideremos un caso práctico. Supongamos que una empresa de energía solar tiene miles de paneles solares conectados a sensores que recopilan datos sobre la generación de energía y las condiciones ambientales. Estos datos se almacenan en bruto y deben procesarse para identificar patrones y tendencias.

Aquí es donde entra en juego Hadoop. Los datos se dividen en lotes manejables y se almacenan en el HDFS. Luego, el Motor de Procesamiento de MapReduce entra en acción: el proceso de «Map» podría involucrar a cada sensor analizando sus datos y emitiendo resultados intermedios. A continuación, el proceso de «Reduce» combina esos resultados para generar un análisis global de la generación de energía, lo que permite a la empresa tomar decisiones informadas sobre mantenimiento, eficiencia y más.

Hadoop ha transformado la forma en que abordamos el procesamiento por lotes en el mundo del Big Data. Su estructura distribuida, escalabilidad y capacidad para manejar conjuntos de datos colosales lo convierten en la piedra angular esencial para la gestión y análisis efectivo de datos masivos. En las secciones siguientes, exploraremos herramientas adicionales que trabajan en armonía con Hadoop para ampliar aún más nuestras capacidades de procesamiento por lotes. Prepárate para sumergirte en un emocionante viaje a través del mundo del Big Data y el procesamiento por lotes.

Imagina que tienes una caja llena de piezas de rompecabezas de datos, y tu tarea es ensamblarlas en una imagen coherente y significativa. Sin embargo, las piezas son numerosas y variadas, y ensamblarlas manualmente sería una tarea titánica. Aquí es donde entra Pig, tu compañero juguetón en el mundo del Big Data. En esta sección, te sumergirás en Pig, una herramienta que hace que el procesamiento por lotes sea más accesible y eficiente, al mismo tiempo que mantiene un toque lúdico en el análisis de datos.

El nombre «Pig» proviene de «Pig Latin», un lenguaje de script que se asemeja al inglés y se diseñó para simplificar y acelerar el análisis de datos en Hadoop. Al igual que un cerdo que puede engullir grandes cantidades de alimento de manera eficiente, Pig se enfoca en digerir montones de datos y transformarlos en información procesable. Pig Latin permite a los usuarios expresar operaciones de análisis de datos en un estilo más natural y declarativo, en lugar de requerir una comprensión profunda de los detalles de implementación subyacentes.

El flujo de trabajo de Pig sigue una estructura que recuerda al ciclo de vida de un cerdo real: ingesta, procesamiento y salida. Comienza con la carga de datos desde diversas fuentes en Pig, donde los datos se almacenan en estructuras llamadas «relaciones». Luego, se aplican transformaciones a estas relaciones utilizando operaciones Pig Latin, que permiten filtrar, agrupar, unir y más. Finalmente, los resultados se escriben en un formato deseado o se almacenan nuevamente en el HDFS.

Imagina que trabajas para una cadena de tiendas minoristas y tienes acceso a un conjunto de datos que contiene información sobre las transacciones de ventas. Utilizando Pig, puedes realizar análisis efectivos sin sumergirte en la complejidad técnica. Supongamos que deseas determinar el promedio de ventas por categoría de productos.

1. Carga de Datos: Cargas el archivo de datos en Pig y lo almacenas en una relación llamada “ventas”.

2. Transformación con Pig Latin: Utilizas Pig Latin para agrupar los datos por categoría de producto y calcular el promedio de ventas para cada categoría.

3. Resultado: El resultado se almacena en una nueva relación llamada «resultado» y se puede exportar para su posterior análisis o presentación.

En este ejemplo, Pig actúa como un intermediario inteligente que simplifica la complejidad del procesamiento por lotes. En lugar de escribir un código MapReduce detallado, utilizas operaciones Pig Latin más legibles y comprensibles.

En resumen, Pig es como un juego de construcción que te permite ensamblar tus datos de manera rápida y efectiva.

Al simplificar el procesamiento por lotes y permitirte expresar tus operaciones en un lenguaje cercano al inglés, Pig se convierte en un aliado valioso en el análisis de datos. En las secciones posteriores, exploraremos otras herramientas que trabajan en armonía con Pig para ampliar aún más nuestro repertorio de procesamiento por lotes en el emocionante mundo del Big Data.

Imagina que estás en un jardín de datos masivos, repleto de información dispersa en diversas formas y tamaños. Ahora, visualiza una colmena organizada y eficiente donde las abejas trabajan juntas para transformar el néctar en miel valiosa. Hive, en el mundo del Big Data, actúa de manera similar, permitiéndote transformar y analizar datos de manera estructurada y eficiente. En esta sección, entraremos en la colmena de Hive y descubriremos cómo esta herramienta esencial facilita la transformación de datos en el procesamiento por lotes.

Hive es como un traductor que convierte comandos familiares de SQL en operaciones de Big Data, permitiéndote interactuar con datos masivos de manera más intuitiva. Al igual que la abeja que recolecta néctar y lo convierte en miel, Hive toma datos en bruto y los transforma en información útil.

En la colmena de Hive, las «tablas» son el corazón de la organización. Puedes crear tablas que se asemejen a hojas de cálculo, especificando columnas y tipos de datos. Por ejemplo, si estás trabajando con datos de ventas, podrías crear una tabla con columnas para ID de producto, cantidad vendida y fecha.

Además, Hive te permite particionar tus datos, lo que es como dividir la colmena en secciones temáticas. Si seguimos con el ejemplo de ventas, podrías particionar tus datos por año y mes, lo que facilitaría consultas específicas basadas en fechas.

Similar al zumbido constante de abejas trabajadoras, Hive QL (Hive Query Language) es el lenguaje que utilizas para interactuar con Hive. Con Hive QL, puedes realizar operaciones familiares de SQL, como SELECT, JOIN y GROUP BY, en tus datos masivos. Por ejemplo, si deseas saber el total de ventas por categoría de producto, simplemente ejecutas una consulta en Hive QL y obtienes los resultados.

Hive no se limita solo a datos en su colmena. Puedes conectar Hive con sistemas de almacenamiento externos, como HBase o Amazon S3, lo que te permite acceder a datos de diversas fuentes y realizar transformaciones en un entorno centralizado. Esto es como si las abejas trajeran néctar de diferentes flores para convertirlo en miel en un solo lugar.

Supongamos que deseas realizar un análisis de ventas utilizando datos almacenados en tu colmena de Hive. Puedes escribir una consulta Hive QL para calcular el total de ventas por categoría de producto durante un período de tiempo específico. Hive manejará automáticamente la distribución y procesamiento de datos en lotes, permitiéndote obtener resultados precisos y eficientes.

En resumen, Hive es como una abeja laboriosa en el mundo del procesamiento por lotes. Transforma tus datos masivos en información útil utilizando operaciones familiares de SQL y aprovechando la capacidad de particionar y consultar datos de manera eficiente. Al igual que una colmena bien organizada, Hive te permite sacar el máximo provecho de tus datos y obtener conocimientos valiosos a partir de ellos.

Imagina que estás en el negocio de la construcción y necesitas trasladar grandes cantidades de materiales desde un lugar a otro. En lugar de llevarlos uno por uno, desearías tener un puente robusto y eficiente que facilite la transferencia sin problemas. Sqoop actúa como ese puente, permitiendo una transferencia rápida y eficiente de datos entre sistemas de almacenamiento relacionales y el ecosistema de Hadoop. En esta sección, nos adentraremos en el mundo de Sqoop y descubriremos cómo esta herramienta esencial facilita la transferencia de datos en el procesamiento por lotes.

Sqoop, cuyo nombre se deriva de «SQL to Hadoop», es una herramienta diseñada para mover datos entre bases de datos relacionales y sistemas de almacenamiento Hadoop, como HDFS o Hive. Al igual que un puente confiable entre dos tierras separadas, Sqoop conecta de manera fluida el mundo de datos estructurados con el vasto ecosistema de Big Data.

Sqoop ofrece dos operaciones principales: importación y exportación de datos. En la importación, puedes traer datos desde una base de datos relacional a Hadoop, lo que permite el análisis y procesamiento por lotes. En la exportación, puedes transferir datos desde Hadoop de regreso a una base de datos relacional, facilitando la persistencia de resultados procesados.

Supongamos que tienes una base de datos en MySQL que almacena datos de ventas de tu negocio. Deseas aprovechar las capacidades de procesamiento por lotes en Hadoop para analizar y obtener información valiosa de esos datos. Entra Sqoop: puedes escribir un comando Sqoop para importar los datos de ventas de MySQL a Hadoop y almacenarlos en HDFS o Hive. Esto permite que los datos estén listos para su procesamiento posterior con herramientas como Hive o Pig.

Al igual que un puente de varios carriles que permite un flujo de tráfico más rápido, Sqoop ofrece opciones para optimizar la transferencia de datos. Puedes realizar importaciones incrementales, lo que significa que solo se transferirán los datos nuevos o modificados desde la última importación. Además, Sqoop permite transferencias paralelas, lo que acelera el proceso dividiendo los datos en partes manejables y transfiriéndolos en paralelo.

En resumen, Sqoop se erige como un puente estratégico en el procesamiento por lotes en el mundo del Big Data. Facilita la transferencia eficiente de datos entre bases de datos relacionales y Hadoop, permitiéndote aprovechar las capacidades de análisis y procesamiento masivo. Al igual que un puente confiable, Sqoop acorta la distancia entre mundos de datos diferentes y te brinda la flexibilidad para moverte de manera eficiente entre ellos.

Imagina que estás en un río caudaloso de información, donde los datos fluyen desde diversas fuentes como arroyos y afluentes. Navegar este río y recopilar todos los datos puede ser una tarea desafiante. Entra Flume, tu confiable barco de datos en el mundo del Big Data. En esta sección, zarparemos en aguas de Flume y exploraremos cómo esta herramienta esencial permite canalizar y transportar datos desde diversas fuentes hacia destinos específicos en el procesamiento por lotes.

Flume se asemeja a un sistema de canalización de agua diseñado para recoger y transportar datos desde diversas fuentes hacia su destino final. Al igual que un barco de carga que lleva mercancías valiosas a través de canales, Flume transporta datos desde puntos de generación (fuentes) hasta sistemas de almacenamiento o procesamiento (destinos).

En el corazón de Flume se encuentran tres componentes clave:

1. Fuentes: Son los puntos de inicio de la canalización, donde los datos ingresan al sistema. Las fuentes pueden ser logs, archivos de registro, eventos de red, o cualquier fuente de datos. Flume recopila datos de estas fuentes y los coloca en el canal.

2. Canales: Actúan como conductos internos que almacenan temporalmente los datos en tránsito. Los canales permiten un flujo más equilibrado entre fuentes y destinos, evitando que la sobrecarga de datos abrume los sistemas.

3. Destinos: Son los puntos finales de la canalización, donde los datos se entregan y almacenan. Los destinos pueden ser bases de datos, HDFS, o cualquier sistema de almacenamiento deseado.

En Flume, configuras flujos de datos definiendo la conexión entre fuentes, canales y destinos. Imagina que estás recopilando registros de actividad de usuarios en un sitio web. Puedes configurar Flume para recopilar estos registros desde las fuentes (servidores web), transportarlos a través de canales (almacenando temporalmente en cola) y finalmente entregarlos a un destino (como HDFS o una base de datos) para su análisis posterior.

Supongamos que deseas recopilar y analizar datos de redes sociales para comprender mejor las tendencias y sentimientos del público hacia tu marca. Flume te permite configurar fuentes para extraer datos de plataformas de redes sociales, como Twitter, y transportarlos a través de canales antes de almacenarlos en un destino para su análisis. Esto te permite obtener información valiosa sobre la percepción de tu marca en tiempo real.

En resumen, Flume es como tu barco de datos confiable en el mundo del procesamiento por lotes. Permite la canalización eficiente de datos desde diversas fuentes hacia destinos específicos, asegurando que la información fluya de manera ordenada y sin obstáculos. Al igual que un capitán experimentado que navega en aguas turbulentas, Flume te guía a través de la recopilación y transporte de datos, allanando el camino para un análisis de datos más efectivo. En las próximas secciones, continuaremos explorando otras herramientas cruciales que se suman a la flota en el emocionante viaje del procesamiento por lotes en el mundo del Big Data.

Imagina que tienes en tus manos una herramienta versátil y poderosa que te permite abordar cualquier tarea, desde tareas diarias hasta desafíos complejos. En el mundo del Big Data, Spark Core se presenta como esa herramienta multifuncional, permitiéndote procesar y analizar datos de manera eficiente y escalable. En esta sección, exploraremos cómo Spark Core empodera el procesamiento por lotes en el mundo del Big Data y desata su potencial.

En el corazón del ecosistema de Apache Spark se encuentra Spark Core, la esencia misma que impulsa el procesamiento por lotes y en tiempo real en un entorno distribuido. Al igual que una chispa que enciende un incendio poderoso, Spark Core enciende la capacidad de procesar grandes volúmenes de datos de manera eficiente y rápida.

Una de las características distintivas de Spark Core es su enfoque en el procesamiento en memoria. En lugar de confiar en el acceso constante a datos en disco, Spark Core carga los datos en la memoria RAM, lo que permite un acceso ultrarrápido y un procesamiento significativamente más rápido. Esto es como tener acceso instantáneo a tu libro favorito en lugar de buscarlo en una estantería.

En Spark Core, los Resilient Distributed Datasets (RDD) son la clave para trabajar con datos de manera abstracta y eficiente. Un RDD es como un conjunto de datos distribuido y tolerante a fallas que se puede operar en paralelo. Imagina que tienes una enorme pila de fichas de dominó (datos) dispuestas en un patrón complejo. RDD sería como una capa que te permite operar en todas las fichas al mismo tiempo, permitiendo operaciones masivas en paralelo.

Supongamos que estás a cargo de analizar registros web de un sitio de comercio electrónico para identificar patrones de compra y tendencias de usuarios. Con Spark Core, puedes cargar los registros en memoria como RDD y realizar operaciones de filtrado, agrupación y análisis sin problemas. Por ejemplo, podrías usar Spark Core para contar la cantidad de compras realizadas en un período específico de tiempo y obtener estadísticas detalladas sobre el comportamiento de compra.

En resumen, Spark Core es como el motor de alto rendimiento en el mundo del procesamiento por lotes en Big Data. Su enfoque en el procesamiento en memoria y su capacidad para trabajar con RDD permiten desatar el potencial oculto en grandes volúmenes de datos. Al igual que una herramienta multifuncional, Spark Core te empodera para abordar una variedad de desafíos de procesamiento de datos de manera eficiente y escalable. En las secciones futuras, continuaremos explorando otras herramientas esenciales que se integran con Spark Core para llevar el procesamiento por lotes a nuevas alturas en el emocionante dominio del Big Data.

Imagina que estás en el horizonte del Big Data, mirando cómo las olas del avance tecnológico se acercan a la orilla. En esta vista panorámica, aparece Spark 2.0 como una ola de innovación, trayendo consigo mejoras y características emocionantes que revolucionan el procesamiento por lotes. En esta sección, exploraremos las novedades y mejoras que Spark 2.0 trae consigo, y cómo estas olas de cambio están remodelando el panorama del análisis de datos.

Spark 2.0 marca un hito en la evolución de Apache Spark, introduciendo mejoras significativas que amplían sus capacidades y aumentan su eficiencia. Al igual que una nueva corriente que fluye hacia un río, Spark 2.0 aporta frescura y dinamismo al procesamiento por lotes en el mundo del Big Data.

Una de las joyas de Spark 2.0 es el Catalyst Optimizer, una herramienta que actúa como un marinero experimentado en un barco, optimizando y acelerando el proceso de consulta. Catalyst se encarga de analizar las consultas y reorganizarlas internamente para reducir la cantidad de trabajo necesario, lo que se traduce en consultas más rápidas y eficientes. Esto es como tener un capitán que ajusta las velas del barco para navegar más rápido y con menos esfuerzo.

Spark 2.0 trae mejoras sustanciales en la manipulación y análisis de datos estructurados con DataFrames y Datasets. Ahora, estas estructuras ofrecen una mayor optimización y herramientas para garantizar la integridad de los datos. Es como tener un arquitecto que refuerza los cimientos de un edificio para que sea más sólido y resistente.

Spark 2.0 da un paso adelante al proporcionar un soporte nativo para el escalado horizontal en Spark SQL. Esto significa que Spark puede manejar consultas que implican una mayor cantidad de nodos y datos distribuidos. Como resultado, las consultas complejas y el análisis en lotes se vuelven más escalables y ágiles, lo que es como tener una carretera de varios carriles en lugar de un estrecho camino.

Supongamos que deseas analizar datos de redes sociales para identificar comunidades y relaciones entre usuarios. Con Spark 2.0, puedes aprovechar el optimizador Catalyst para agilizar las consultas y el análisis de datos. Además, las mejoras en DataFrame y Dataset te permiten trabajar con datos estructurados de manera más eficiente y segura. Esto te brinda la capacidad de realizar análisis de redes sociales a gran escala con mayor rapidez y confiabilidad.

En resumen, Spark 2.0 es como una ola de innovación que impulsa el procesamiento por lotes a nuevas alturas en el mundo del Big Data. Con características como el Catalyst Optimizer, mejoras en DataFrames y Datasets, y soporte para escalado horizontal, Spark 2.0 redefine la forma en que abordamos el análisis de datos a gran escala. Al igual que un navegante experto, Spark 2.0 te guía a través de aguas más rápidas y eficientes, allanando el camino para un procesamiento por lotes más poderoso y versátil.

Imagina que estás organizando un equipo de expertos en diferentes disciplinas para resolver un problema complejo. Cada miembro aporta su experiencia única y, juntos, crean una solución integral y poderosa. En el mundo del Big Data, la integración estratégica desempeña un papel similar, al tejer una red de colaboración entre herramientas esenciales. En esta sección, exploraremos cómo la integración estratégica permite que las herramientas colaboren de manera sinérgica, maximizando el potencial del procesamiento por lotes.

La integración estratégica es como la construcción de puentes entre islas de funcionalidad. Permite que herramientas individuales se conecten y compartan datos de manera armoniosa, creando un ecosistema de procesamiento por lotes más poderoso y eficiente. Al igual que una red de comunicación entre equipos en una empresa, la integración estratégica fomenta la colaboración y el flujo de información entre herramientas.

Imagina que estás utilizando Hive para realizar análisis de datos estructurados y Spark Core para procesar datos en memoria. La integración estratégica permite que estas dos herramientas colaboren sin problemas. Puedes utilizar Spark Core para cargar datos en memoria y luego usar Hive para realizar análisis SQL avanzados en esos datos. Esto es como tener un equipo de analistas de datos y científicos trabajando juntos para desentrañar información valiosa.

Flume se especializa en la recopilación y transporte de datos, mientras que Sqoop es experto en transferir datos entre sistemas. La integración estratégica entre estas dos herramientas permite una canalización sin interrupciones de datos desde diversas fuentes hasta los destinos deseados. Es como tener una cadena de suministro bien coordinada que garantiza que los datos fluyan de manera eficiente y se entreguen donde se necesiten.

Supongamos que deseas realizar análisis en tiempo real de datos de sensores en tu empresa. Flume puede recopilar los datos de los sensores y enviarlos a Spark para un análisis inmediato. La integración estratégica entre Flume y Spark permite que los datos fluyan de manera continua, lo que te brinda información en tiempo real sobre el rendimiento de los sensores y posibles problemas. Esto es como tener un equipo de monitoreo constante que alerta sobre cualquier situación crítica.

En resumen, la integración estratégica es como tejer una red de colaboración entre herramientas en el procesamiento por lotes del Big Data. Permite que las herramientas trabajen juntas en armonía, aprovechando sus fortalezas individuales para lograr un resultado más poderoso y completo. Al igual que un equipo diverso de expertos que aportan su conocimiento único, la integración estratégica une herramientas para abordar desafíos de procesamiento por lotes de manera efectiva y eficiente. En las secciones futuras, continuaremos explorando cómo estas redes de colaboración se expanden y enriquecen en el emocionante dominio del Big Data.

Imagina que eres el analista de datos de una empresa que busca comprender y optimizar su presencia en las redes sociales. Tu misión es recopilar, procesar y analizar datos de redes sociales para obtener información valiosa sobre el comportamiento de los usuarios y las tendencias en línea. En este caso de uso completo, te sumergirás en el emocionante mundo del análisis de datos de redes sociales utilizando herramientas como Hadoop, Pig, Hive y Spark Core.

Comenzamos por recopilar datos de redes sociales. Flume entra en acción aquí, recopilando publicaciones, comentarios y menciones de redes sociales como Twitter y Facebook. Configuras fuentes para extraer datos en tiempo real y los envías a través de canales para que lleguen a su destino, en este caso, almacenamiento en HDFS.

Una vez que los datos están en HDFS, es hora de preprocesarlos y transformarlos para un análisis más significativo. Pig se convierte en tu aliado aquí. Utilizas Pig Latin para limpiar los datos, eliminar duplicados, realizar tokenización y generar una estructura coherente. Por ejemplo, puedes convertir texto no estructurado en una tabla organizada con columnas para el autor, el contenido y la fecha.

Con los datos limpios y organizados, es el momento de profundizar en el análisis. Utilizas Hive para realizar consultas SQL sobre los datos. Por ejemplo, puedes calcular el conteo de menciones positivas y negativas hacia tu marca en función de las palabras clave identificadas en los comentarios.

Además, aprovechas Spark Core para llevar a cabo análisis más complejos en memoria. Utilizas la capacidad de procesamiento en memoria de Spark para detectar tendencias en tiempo real, como qué temas se vuelven populares en las redes sociales y cómo cambian las conversaciones a lo largo del tiempo.

Con los análisis completados, es hora de visualizar y presentar los resultados. Utilizas herramientas como Tableau o Power BI para crear gráficos, tablas y paneles interactivos que representen claramente los hallazgos. Puedes mostrar visualmente la evolución de las menciones de tu marca, la distribución geográfica de los usuarios y las principales tendencias discutidas.

Basándote en los conocimientos obtenidos, puedes tomar medidas estratégicas. Por ejemplo, si descubres que un producto específico tiene una alta tasa de menciones negativas, puedes tomar medidas para mejorar su calidad o cambiar tu estrategia de marketing. Además, puedes ajustar tu contenido para aprovechar las tendencias emergentes y maximizar la interacción con los usuarios.

En resumen, este caso de uso completo ilustra cómo el análisis de datos de redes sociales puede generar información valiosa para la toma de decisiones estratégicas. Desde la recopilación inicial hasta el análisis avanzado y la visualización de resultados, las herramientas como Flume, Pig, Hive y Spark Core se combinan para permitir que los datos sociales se conviertan en oportunidades estratégicas. Al igual que un detective que desentraña pistas ocultas en un caso, tú como analista de datos desentrañas información valiosa de las redes sociales para impulsar el éxito de tu empresa.

Imagina que estás navegando en un océano de datos, enfrentando olas desafiantes mientras buscas un tesoro de información valiosa. En el emocionante mundo del procesamiento por lotes, también enfrentamos desafíos y olas de datos turbulentos. En esta sección, exploraremos cómo superar los desafíos y optimizar el proceso de procesamiento por lotes utilizando estrategias inteligentes y herramientas clave.

El procesamiento por lotes no está exento de desafíos. Encontramos olas como la escalabilidad, la eficiencia y la gestión de recursos, que pueden dificultar la navegación hacia un análisis de datos efectivo. Sin embargo, estos desafíos pueden ser superados con enfoque y estrategia.

Hadoop se presenta como una embarcación robusta para enfrentar los desafíos de la escalabilidad. La distribución y paralelismo que ofrece Hadoop te permiten procesar grandes volúmenes de datos de manera efectiva. Al igual que un barco capaz de navegar en aguas profundas, Hadoop navega a través de oleadas de datos, permitiendo que tu procesamiento por lotes sea fluido y eficiente.

Spark se convierte en tus velas para aprovechar el viento de la optimización. La capacidad de procesamiento en memoria de Spark acelera el análisis y reduce el tiempo de respuesta. Al igual que ajustar las velas para aprovechar al máximo la fuerza del viento, Spark te permite optimizar el rendimiento de tus análisis de datos.

YARN actúa como el timonel experto que maneja la distribución de recursos de manera eficiente. Al asignar recursos de manera inteligente a las aplicaciones, YARN evita la sobrecarga y garantiza un procesamiento por lotes sin problemas. Es como un timonel experimentado que mantiene el barco en curso, evitando aguas turbulentas y garantizando un viaje seguro.

El sistema de archivos distribuido de Hadoop (HDFS) actúa como el casco resistente del barco que garantiza la resiliencia y la tolerancia a fallos. HDFS almacena y replica datos en varios nodos, asegurando que no se pierdan en caso de problemas. Al igual que un casco sólido que protege al barco en aguas cambiantes, HDFS garantiza que tus datos estén seguros y disponibles en todo momento.

En resumen, superar desafíos y optimizar el proceso de procesamiento por lotes es como navegar en aguas agitadas. Utilizando herramientas inteligentes como Hadoop, Spark, YARN y HDFS, puedes enfrentar olas de datos con confianza y eficiencia. Al igual que un capitán experto que navega hábilmente a través de los desafíos, tú como analista de datos puedes navegar hacia el éxito en el emocionante viaje del procesamiento por lotes en el mundo del Big Data. En las próximas secciones, continuaremos explorando más destrezas y herramientas que enriquecen nuestra travesía en este vasto océano de información.

Imagina que estás mirando al horizonte en un día despejado, contemplando el vasto océano del Big Data. A medida que avanzamos en el tiempo, el procesamiento por lotes en este universo está evolucionando y abriendo nuevos horizontes. En esta sección, exploraremos las tendencias emergentes y el emocionante futuro que aguarda al procesamiento por lotes en el mundo del Big Data.

El futuro del procesamiento por lotes promete un paisaje rico en innovación y oportunidades. A medida que las tecnologías avanzan y las demandas de datos se vuelven más complejas, el procesamiento por lotes se adapta y transforma para abordar los desafíos emergentes.

Uno de los horizontes más emocionantes es la convergencia del procesamiento por lotes y en tiempo real. Las fronteras entre ambos se desdibujan, permitiendo que el análisis y la toma de decisiones ocurran casi instantáneamente. Esto es como fusionar un barco de carreras con uno de exploración: puedes navegar rápido mientras exploras nuevas aguas de análisis.

A medida que avanzamos, la automatización y el aprendizaje automático se entrelazan con el procesamiento por lotes. Las herramientas serán más inteligentes para comprender patrones y tomar decisiones informadas por sí mismas. Imagina tener un timonel virtual que ajusta el rumbo del barco según las condiciones cambiantes del mar.

La nube se convierte en una plataforma esencial en el futuro del procesamiento por lotes. Ofrece una escalabilidad prácticamente infinita y recursos bajo demanda, lo que permite abordar conjuntos de datos cada vez más grandes y complejos. Esto es como tener un barco que se transforma en un transatlántico en cuestión de segundos, adaptándose a las necesidades cambiantes.

A medida que los datos se vuelven más valiosos, la seguridad y la privacidad se convierten en un enfoque central. En el futuro, el procesamiento por lotes incorporará protocolos de seguridad más sólidos y métodos avanzados de protección de datos. Como un barco con cascos reforzados, el procesamiento por lotes se asegurará de que los datos naveguen en aguas claras y transparentes.

En resumen, el futuro del procesamiento por lotes en el universo del Big Data es como una emocionante expedición hacia nuevos horizontes. A medida que el procesamiento por lotes se entrelaza con la velocidad del tiempo real, se automatiza con la inteligencia artificial y se expande en la nube, navegamos hacia un futuro prometedor de análisis de datos más rápido, más inteligente y más escalable. Al igual que un explorador en un barco bien equipado, estamos preparados para descubrir nuevas islas de conocimiento y oportunidades en este vasto océano de información.

El viaje a través del arte del procesamiento por lotes en el mundo del Big Data ha sido como una travesía emocionante por aguas desconocidas. Hemos explorado herramientas esenciales como Hadoop, Pig, Hive, Sqoop, Flume, Spark Core y Spark 2.0, y hemos navegado por olas de desafíos y oportunidades. En esta conclusión, resumiremos nuestros aprendizajes y reflexionaremos sobre cómo hemos dominado este arte.

Hemos establecido una base sólida al comprender los fundamentos de Hadoop y su ecosistema, la transformación de datos con Pig, el análisis con Hive, la transferencia eficiente con Sqoop, la canalización de datos con Flume y el empoderamiento con Spark Core y Spark 2.0. Al igual que un marinero experimentado, hemos aprendido a maniobrar nuestras herramientas con destreza.

Hemos descubierto cómo tejer una red de colaboración entre herramientas para un procesamiento por lotes más completo y eficiente. Al igual que un capitán que coordina a su tripulación, hemos aprendido a aprovechar las fortalezas únicas de cada herramienta para lograr resultados sinérgicos en el análisis de datos.

Hemos enfrentado desafíos y optimizado el proceso de procesamiento por lotes, como navegantes hábiles en aguas agitadas. Hadoop, Spark, YARN y HDFS han sido nuestras herramientas para superar las marejadas de datos y maximizar la eficiencia en el análisis.

Hemos contemplado el emocionante horizonte del futuro del procesamiento por lotes en el Big Data. A medida que convergen el procesamiento por lotes y en tiempo real, la automatización y el aprendizaje automático se entrelazan, y la nube se convierte en la plataforma clave, estamos preparados para navegar hacia un futuro de análisis de datos más inteligente y escalable.

En resumen, hemos navegado con maestría en el arte del procesamiento por lotes en el universo del Big Data. Hemos aprendido a aprovechar las herramientas clave, tejer colaboración entre ellas, superar desafíos y mirar hacia el emocionante futuro. Al igual que capitanes intrépidos, estamos listos para liderar en el mundo del procesamiento por lotes, transformando datos en conocimientos y oportunidades estratégicas. Nuestro viaje no termina aquí; en cada nuevo proyecto, seremos los navegantes expertos que guían a nuestro equipo a través de las aguas cambiantes del Big Data.